-

[Machine Learning] 커널 능형 회귀(Kernel Ridge Regression)Informatik 2022. 3. 2. 01:10

※ [Machine Learning] 회귀(Regression)

[Machine Learning] 회귀(Regression)

통계학에서 회귀 분석이란 관찰된 연속형 변수들에 대해 두 변수 사이의 모형을 구한 뒤 적합도를 측정해 내는 분석 방법이다. [wikipedia] 분류(Classification) vs. 회귀(Regression) 분류는

minicokr.com

※ [Machine Learning] 언더 피팅과 오버 피팅(Underfitting and Overfitting)

[Machine Learning] 언더 피팅과 오버 피팅(Underfitting and Overfitting)

일반적으로 학습 데이터는 실제 데이터의 부분 집합이므로 학습 데이터에 대해서 오차가 감소하지만 실제 데이터에 대해서 오차가 증가하는데, 이 현상을 오버 피팅이라고 부른다. [wikipedia]

minicokr.com

능형 회귀(Ridge Regression)

SRM(Structural Risk Minimization) 원리로 클래스 함수(Class Function)를 제한하는 모델을 선택한다. 따라서 능형 회귀의 최적화 문제는 다음과 같다.

라그랑주 승수법(Lagrage Multiplier)으로 최적

최소 제곱 오차(Least Square Error):

최소 제곱 오차의 최적

※ [Machine Learning] 단순 선형 회귀(Simple Linear Regression)

[Machine Learning] 단순 선형 회귀(Simple Linear Regression)

※ [Machine Learning] 회귀(Regression) [Machine Learning] 회귀(Regression) 통계학에서 회귀 분석이란 관찰된 연속형 변수들에 대해 두 변수 사이의 모형을 구한 뒤 적합도를 측정해 내는 분석 방법이다. [wi..

minicokr.com

※ [Machine Learning] 다중 선형 회귀(Multiple Linear Regression)

[Machine Learning] 다중 선형 회귀(Multiple Linear Regression)

※ [Machine Learning] 회귀(Regression) 공부하기 [Machine Learning] 회귀(Regression) 통계학에서 회귀 분석이란 관찰된 연속형 변수들에 대해 두 변수 사이의 모형을 구한 뒤 적합도를 측정해 내는 분석 방법..

minicokr.com

항상 선형적인 모델

※ [Machine Learning] 커널 기법(Kernel Method): 커널 트릭(Kernel Trick), 서포트 벡터 머신(Support Vector Machine)

[Machine Learning] 커널 기법(Kernel Method): 커널 트릭(Kernel Trick), 서포트 벡터 머신(Support Vector Machine)

기계 학습에서 회귀(Regression)나

minicokr.com

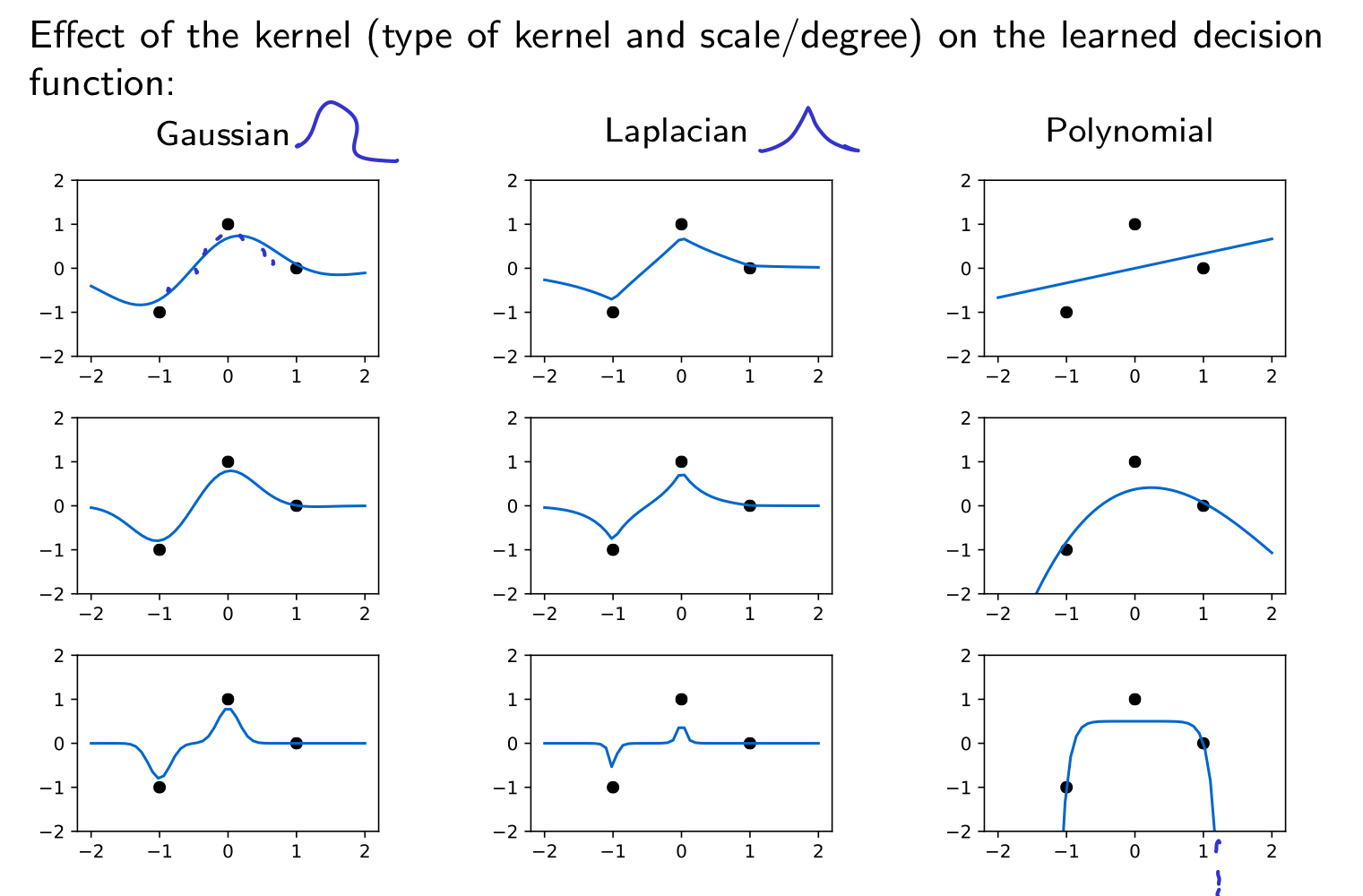

커널 능형 회귀(Kernel Ridge Regression)

모델을 재정의 하여,

새로운 데이터는 다음과 같이 회귀한다.

커널 기법(Kernel Method)에서 배웠듯이

커널 트릭을 적용할 수 있도록 재정리 커널 함수가 함수

1. Richard O. Duda, Peter E. Hart, and David G. Stork. 2000. Pattern Classification (2nd Edition). Wiley-Interscience, USA.

2. Müller, K.R., Montavon, G. (2021). Lecture on Machine Learning 1-X. Technische Universität Berlin, Berlin, Germany.

'Informatik' 카테고리의 다른 글