-

[Machine Learning] 선형 분류(Linear Classification)Informatik 2022. 1. 20. 20:40

선형 분류는 일차원 혹은 다차원 데이터들을 선형 모델(Linear Model)을 이용하여 클래스들로 분류(Classification)하는 머신러닝(Machine Learning) 기법이다. 아래 예시는 2차원 데이터를 어떤 선형 모델로

2차원 데이터의 선형 분류 - 선형 판별 함수(Linear Discriminant Function): 클래스 분류의 기준이 될 수 있는 판별 함수(Discriminant Function)가 선형적이다.

- 분류 규칙(Classification Rule):

- 결정 경계(Decision Boundary):

- 클래스 영역(Class Regions):

아래의 그림은 3차원 데이터의 2차원 선형면으로 분류하는 자세한 예를 보여준다.

3차원 데이터의 선형 분류 - 선형 판별 함수:

- 결정 경계:

3차원 데이터

점

- 원점 (0, 0, 0)과 초평면까지의 최소 거리:

위에서처럼 학습 데이터(Training Data)를 초평면에 정사 영시 킨 후, 그 거리의 부호를 구하면 이진 분류(Binary Classification)가 가능하다.

※ 증명

※

경험적 위험도 최소화(Empirical Risk Minimization)

이렇게 분류한 모델이 잘 분류되었는지 판단하려면 어떤 기준점이 필요한데, 이를 위해 경험적 위험도 최소화(ERM) 방법을 사용한다. ERM의 핵심은 다음과 같다.

분류 결과에 대한 손실 함수(Loss Function)를 설정해 잘못 분류됐을 경우 페널티(Penalty)를 부여 → 각 예측된 분류 결과에 대한 기대 손실 값인 기대 위험도를 최소화(Expected Risk Minimization) → 학습 데이터만으로 기대 위험도를 구할 수 없으니 경험적 위험도를 대신 최소화

손실 함수(Loss Function)

손실 함수

[Machine Learning] 베이즈 결정 이론(Bayesian Decision Theory)

지도 학습(Supervised Learning)의 분류(Classification)에 해당하는 머신러닝(Machine Learning) 기법인 베이즈 결정 이론은 일상생활에서 흔하게 볼 수 있고 사용할 수 있는 기법이다. 예를 들어, 스팸 메일을.

minicokr.tistory.com

Q. ERM에서 제로-원 손실 함수(Zero-One Loss Function)가 적합하지 않은 이유는?

A. 제로-원 손실 함수는 불연속 계단 함수(Discontinuous Step Function)로 비 볼록 함수(Non-Convex Function)이기도 하다. 따라서 제로-원 손실을 이용한 ERM은 NP-난해(NP-Hard) 문제이며, 미분을 이용한 해결 방식인 경사 하강법(Gradient Descent)을 적용할 수가 없다.

예 1) 로지스틱 손실(Logistic Loss)

아래의 그래프는 (a) 제로-원 손실, (b) 제곱 손실(Squared Loss) (c) 로지스틱 손실에 대한 경험적 위험도를 도면화하였다. 제곱 손실과 로지스틱 손실은 아래가 완만한 반면 제로-원 손실은 계단 함수 형태를 보여준다.

세가지 손실 함수에 대한 경험적 위험도

대리 손실 함수(Surrogate Loss Function)

Q. 기대 위험도 최소화 대신 ERM을 사용할 수 있는 경우는?

A. 손실 함수

피셔의 일치성(Fisher Consistency)이라고 하며, 이가 만족되어야 ERM으로 기대 위험도 취소화를 대신할 수 있다.피셔의 일치성(Fisher Consistency):

For any sequence

피셔의 일치성으로 제로-원 손실 함수는 적합하지 않음을 다시 한번 확인할 수 있다.

ERM의 구체적인 예시

※ 참고

학습 세트의 개수(Number of training examples) 특성의 개수(Number of features) 클래스 레이블(Class labels) 모수 벡터(Parameter Vector) 증강된 특성 벡터(Augmented Feature Vector) ERM: 아래의 조건에서 경험적 위험도

- 학습 세트(Training Set)

- 가설 공간(Hypothesis Space)

- 볼록 손실 함수(Convex Loss Function)

예 1) 일반화된 ERM

- 일반화된 손실 함수(General Loss Function)

- 경험적 위험도

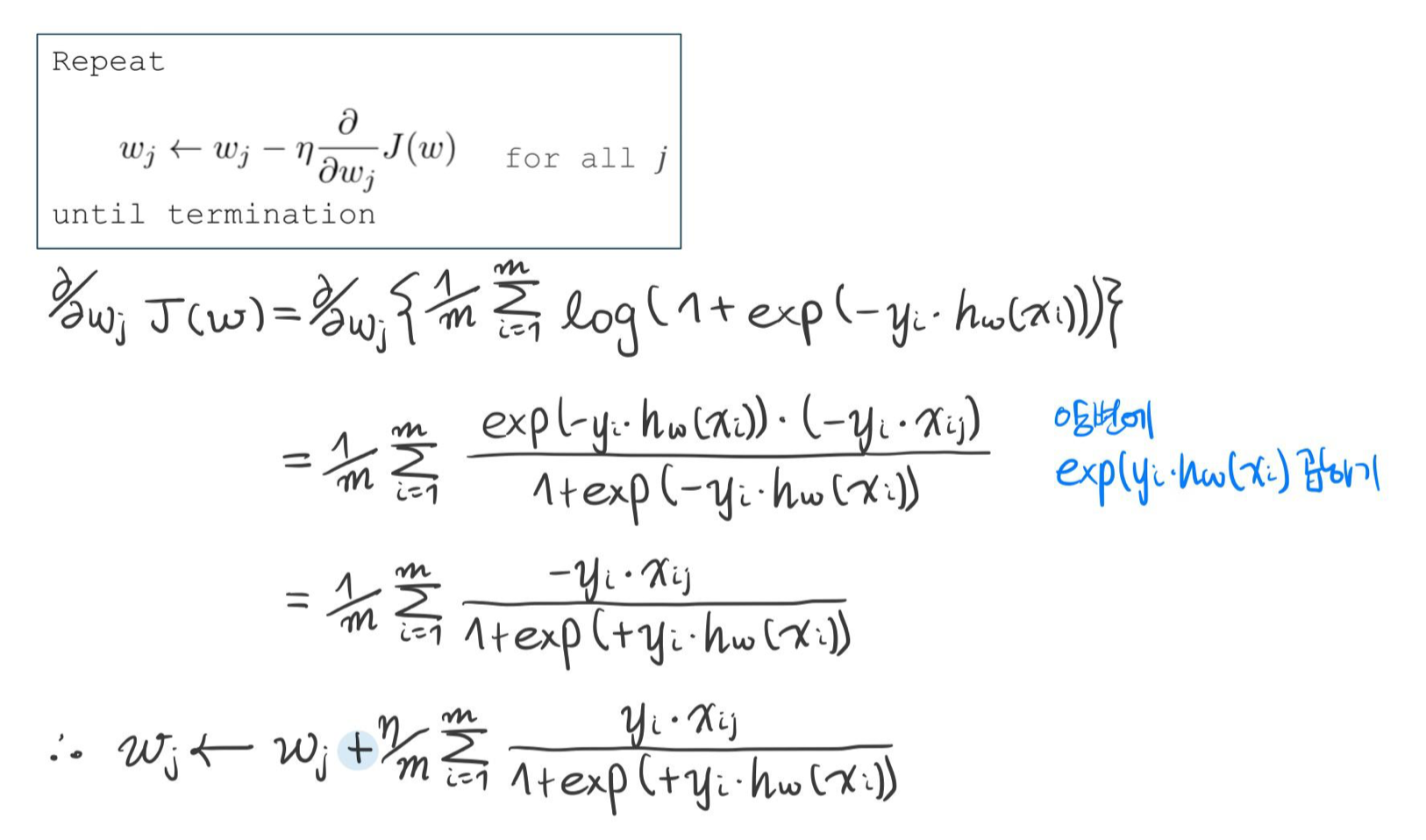

- 경사 하강법 종료 시까지 반복

예 2) 선형 회귀(Linear Regression)

- 제곱 손실 함수

- 경험적 위험도

- 경사 하강법 종료 시까지 반복

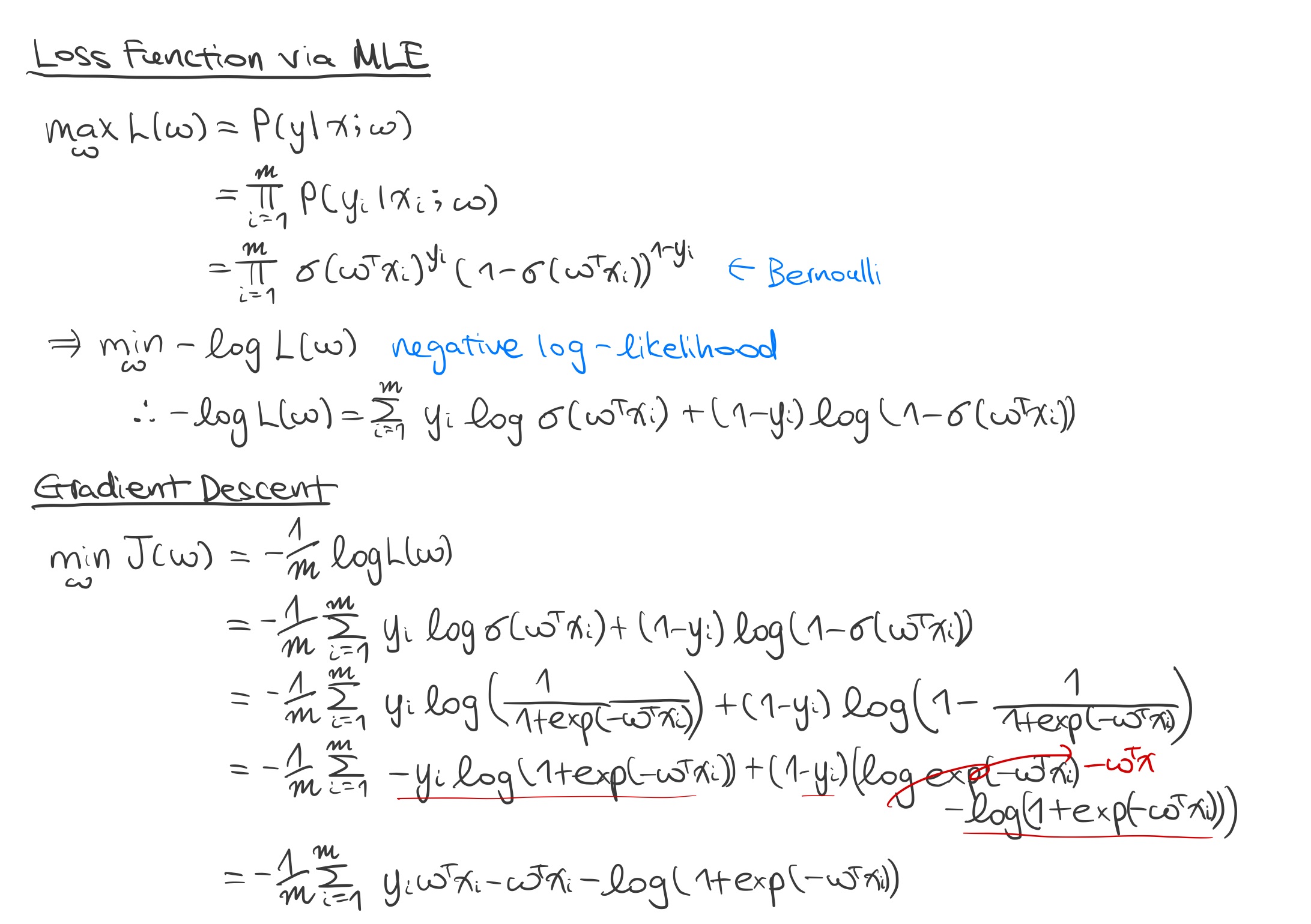

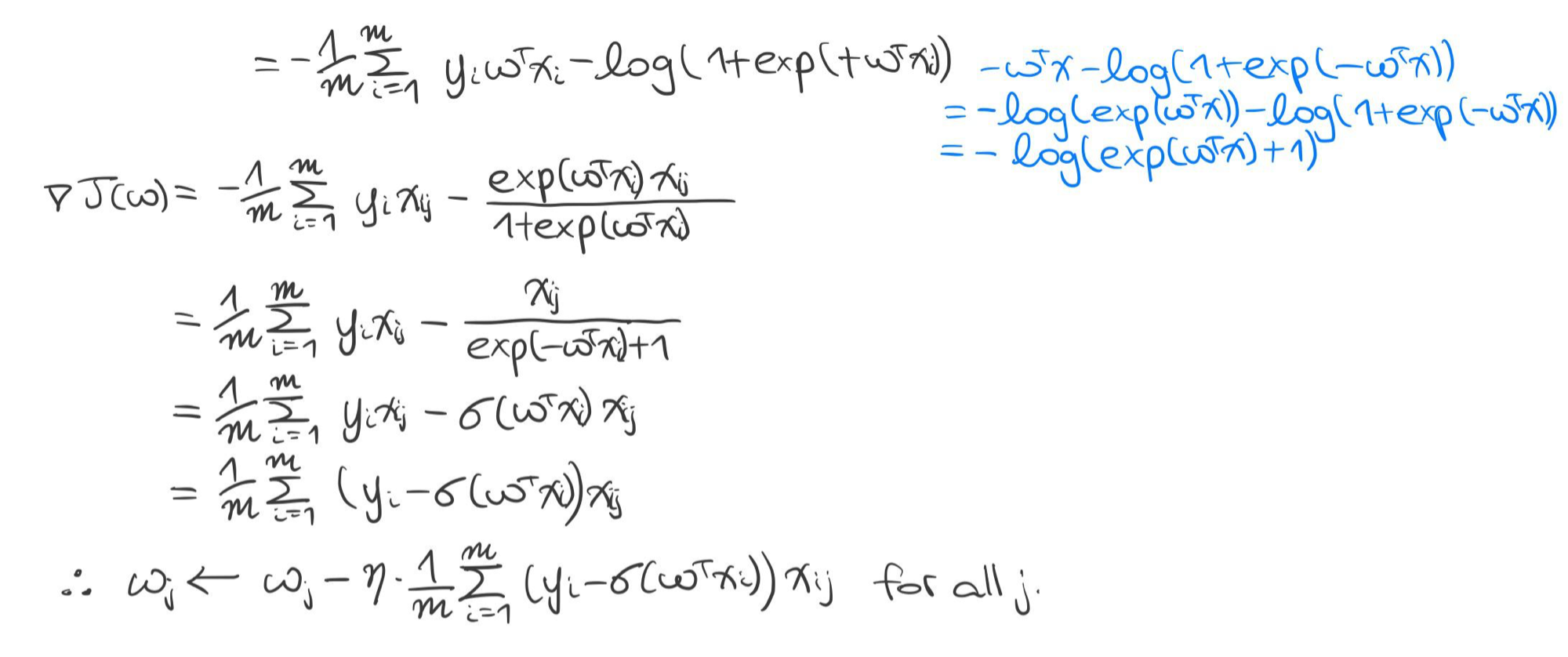

예 3) 로지스틱 회귀(Logistic Regression)

- 로지스틱 손실 함수

- 경험적 위험도

- 경사 하강법 종료 시까지 반복

※ 로지스틱 회귀의 증명

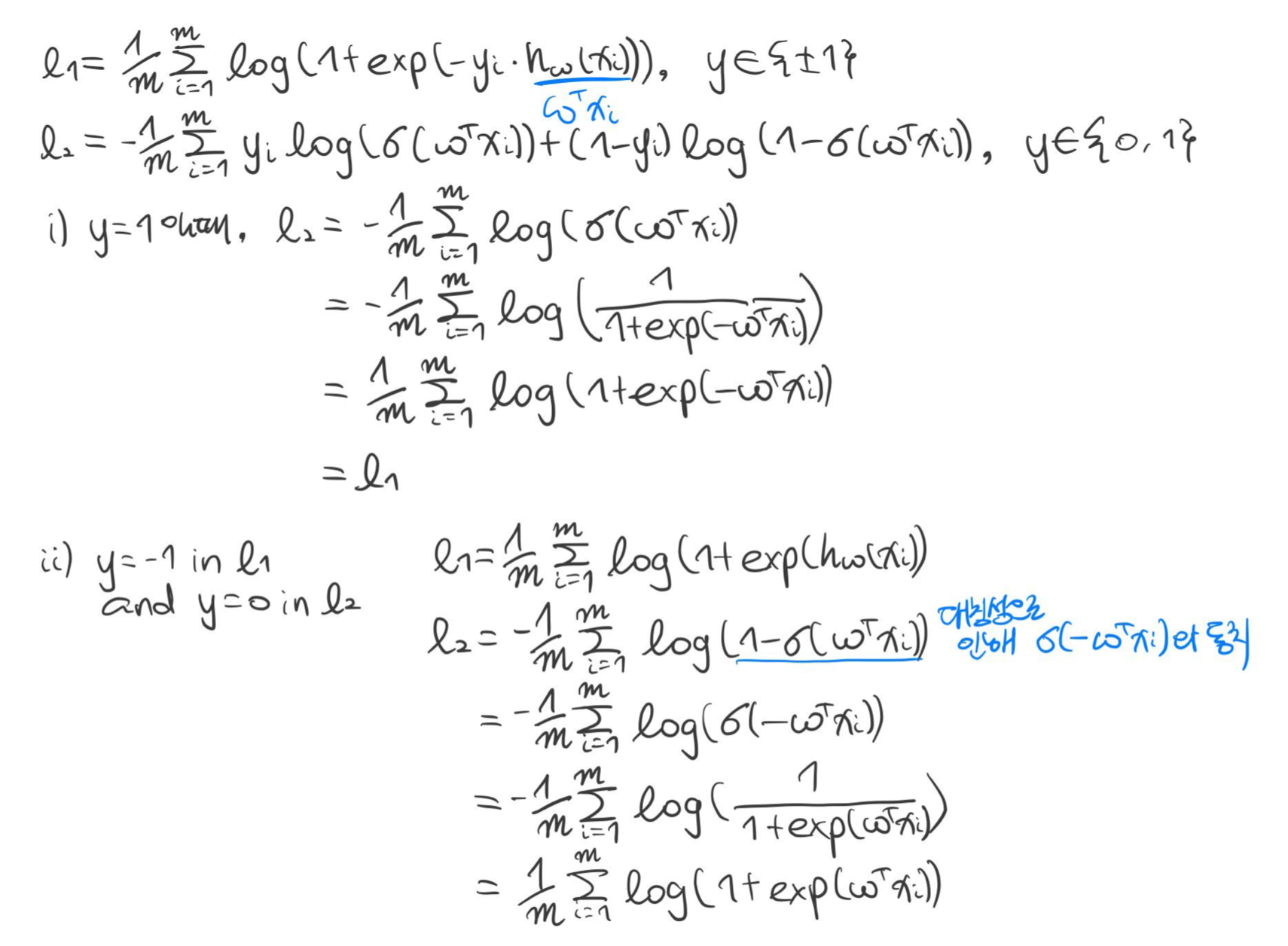

※ 로지스틱 회귀의 또 다른 표현법. (두 식에서 가질 수 있는 클래스의 값이 다르다.)

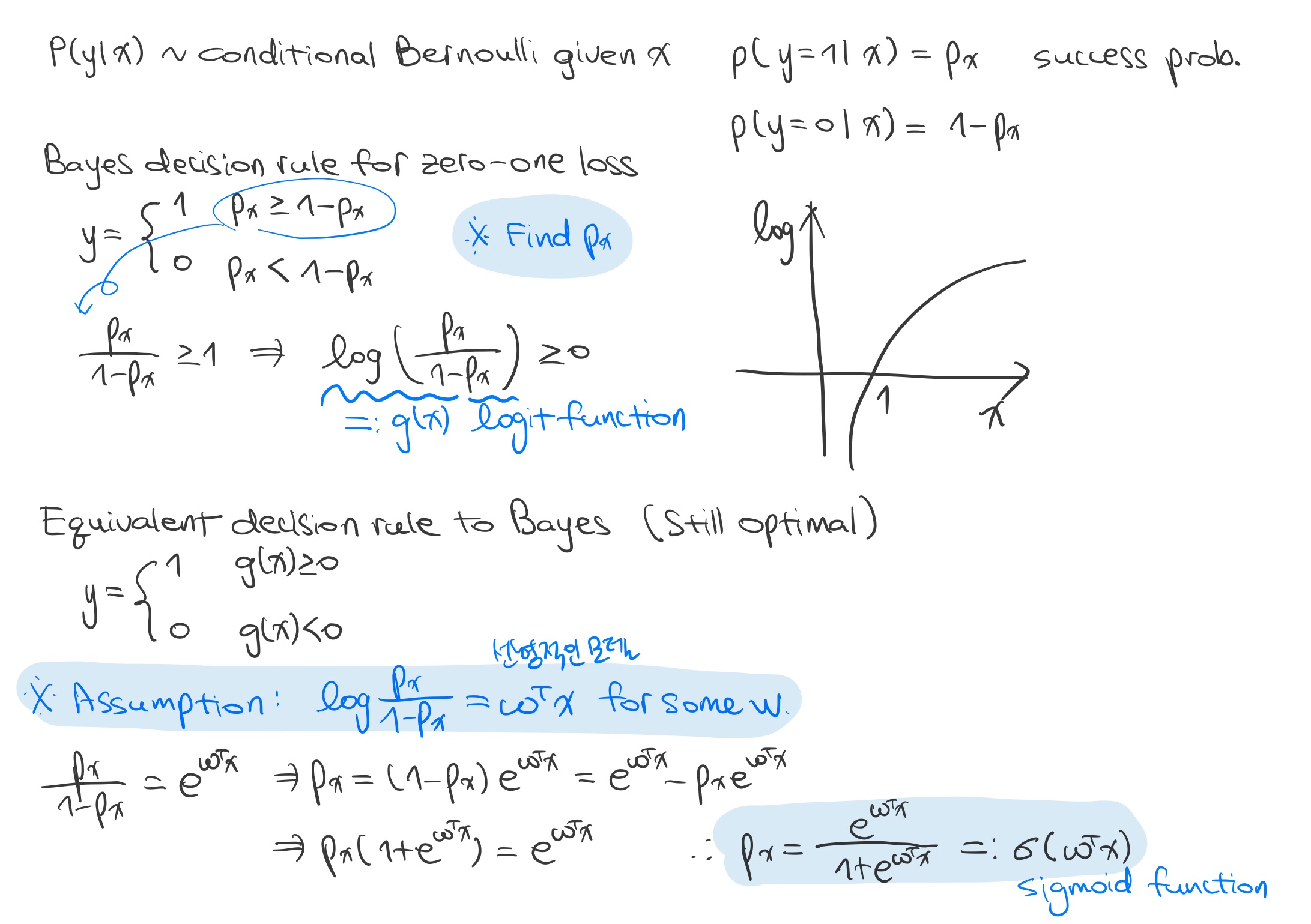

※ 로지스틱 회귀의 확률적 해석

※ [Machine Learning] 퍼셉트론 인공신경망(Perceptron Artificial Neural Network)

[Machine Learning] 퍼셉트론 인공신경망(Perceptron Artificial Neural Network)

※ [Machine Learning] 선형 분류(Linear Classification) [Machine Learning] 선형 분류(Linear Classification) 선형 분류는 일차원 혹은 다차원 데이터들을 선형 모델(Linear Model)을 이용하여 클래스들로 분..

minicokr.com

※ [Machine Learning] 피셔의 선형 판별 분석(Fisher Linear Discriminant Analysis)

[Machine Learning] 피셔의 선형 판별 분석(Fisher Linear Discriminant Analysis)

※ [Machine Learning] 상관계수(Correlation Coefficient) [Machine Learning] 상관계수(Correlation Coefficient) 상관계수는 두 변수 사이의 통계적 관계를 표현하기 위해 특정한 상관관계의 정도를 수치적으로..

minicokr.com

1. Richard O. Duda, Peter E. Hart, and David G. Stork. 2000. Pattern Classification (2nd Edition). Wiley-Interscience, USA.

'Informatik' 카테고리의 다른 글

[Machine Learning] PCA(Principal Component Analysis) (0) 2022.02.09 [Machine Learning] 최대우도법 vs. 베이즈 추정법(Maximum Likelihood Estimation vs. Bayesian Estimation) (0) 2022.01.31 [Machine Learning] 단순 선형 회귀(Simple Linear Regression) (0) 2022.01.28 [Machine Learning] 회귀(Regression) (0) 2022.01.23 [Machine Learning] 베이즈 결정 이론(Bayesian Decision Theory) (0) 2022.01.14 - 선형 판별 함수(Linear Discriminant Function): 클래스 분류의 기준이 될 수 있는 판별 함수(Discriminant Function)가 선형적이다.